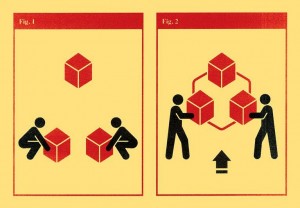

利用大数据集的11个技巧

大数据通常难以管理和使用。这些窍门有助于更高效地管理和使用大数据。

在研究中,大数据无处不在,而且数据集只会越来越大,处理起来也会越来越有挑战性。Tracy Teal指出,处理大数据是一种经常被排除在科学训练之外的劳动。在研究领域有一种风气,那就是忽视管理和共享数据所需的时间和努力,而不把它视为科学研究的一部分。但是,她建议,我们可以转变观念,把数据管理工作视为研究过程的一部分,而不是把它当作事后的想法。

这里有11个技巧可以让你最大限度地利用你的大数据集。

1. 珍惜数据

Teal建议,保留原始数据,不要在没有副本的情况下对原始数据进行操作;将数据存储在能够自动备份的地方,让其他实验室成员可以访问,同时遵守所在机构关于知情同意和数据隐私的规则。鉴于你不需要经常访问这些数据,你可以使用存储服务——例如,亚马逊的冰川服务。虽然访问数据成本较高,但服务存储成本很低。你甚至可以将原始数据存储在保存在不同位置的重复硬盘上。大数据文件的存储成本可能会增加,因此要相应地进行预算。

2. 信息可视化

加州大学戴维斯分校(University of California, Davis)的生物信息学家Titus Brown指出,随着数据集越来越大,新的问题越来越多。在每个阶段都会遇到新的、令人兴奋的各种问题。他的建议是做大量的图表,寻找异常值。去年4月,Brown的一个学生分析了678种海洋微生物(如浮游生物)的转录组(一个细胞或生物体产生的全部RNA分子)(L. K. Johnson et al. GigaScience 8, giy158; 2019)。当Brown和他的学生为转录本长度、覆盖范围和基因含量绘制平均值时,他们注意到有些值为零——这表明计算工作流程失败了,必须重新运行。

3. 展示工作流程

粒子物理学家Peter Elmer在辅导11岁的儿子完成数学作业时,不得不提醒儿子记录下自己的步骤。但他儿子只想把答案写下来。Elmer是新泽西州普林斯顿大学(Princeton University)高能物理软件研究与创新研究所(Institute for Research and Innovation in Software for High Energy Physics)的执行主任。研究大数据集的研究人员可以从Elmer给他儿子的建议中受益:展示你的工作流程和完成工作一样重要。

这意味着记录整个数据工作流——使用的数据版本、梳理和质量检查步骤,以及运行的任何处理代码。这些信息对于记录和复制你的方法是非常宝贵的。Eric Lyons是图森市亚利桑那大学(University of Arizona)的计算生物学家,他使用视频捕捉工具asciinema来记录他在命令行中输入的内容,但是低技术的解决方案也可以工作。据他回忆,他的一群同事拍下了他们电脑屏幕上的照片,并把它们发布到实验室的即时信息平台Slack上。

4. 使用版本控制

版本控制系统使研究人员能够准确地了解文件是如何随时间变化的,以及是谁做了这些变化。但有些系统会限制您可以使用的文件的大小。哈佛大学(Harvard University)的天体物理学家和数据可视化专家Alyssa Goodman指出,哈佛Dataverse(对所有研究人员开放)和Zenodo可以用于大型文件的版本控制。另一个选择是Dat,一个免费的对等网络,用于共享和版本控制任何大小的文件。哥本哈根Dat产品的核心软件开发人员Andrew Osheroff表示,系统一直在维护一个防篡改日志,记录你对文件执行的所有操作。位于加州奥克兰的Dat产品经理Karissa McKelvey指出,用户可以指导系统存档每个版本的文件副本。Dat目前是一个命令行实用程序,但McKelvey表示,他们一直在积极改进。该团队希望今年晚些时候发布一个更友好的前端。

5. 记录元数据

Teal表示,除非其他人和‘未来的你’知道每个数据的来源,否则你的数据是没有用处的。这就是元数据的工作,它描述如何收集、格式化和整合观察结果。Lyons建议,在开始收集之前,就要认真考虑要记录哪些元数据,并将这些信息与数据一起存储在用于收集观察结果的软件工具或自述文件或其他专用文件中。由马里兰州巴尔的摩约翰霍普金斯大学(Johns Hopkins University)神经统计学家Joshua Vogelstein领导的开放连接体项目(Open Connectome Project),以一种名为JSON的结构化纯文本格式记录元数据。Lyons提醒,不管你的策略是什么,试着从长远考虑,因为也许有一天你会想把你的数据和其他实验室的数据整合起来。如果你对元数据有前瞻性,那么这种整合将更容易实现。

6. 自动化,自动化,自动化(重要的事情说三遍)

华盛顿州西雅图艾伦脑科学研究所(Allen Institute for Brain Science)数据和技术高级主管Shoaib Mufti表示,大规模数据集太大了,根本无法手动梳理,鉴于此,自动化才是关键。例如,该研究所的神经信息学团队使用了一个用于脑细胞和遗传学数据的模板,该模板只接受正确格式和类型的信息。当需要将这些数据集成到更大的数据库或集合中时,可以使用Apache Spark和Apache Hbase这两种开源工具自动执行数据质量保证步骤,以实时验证和修复数据。Mufti指出,他们的整套软件工具可以在云中验证和接收数据,这使得他们可以轻松地进行扩展。Vogelstein指出,Open Connectome项目还提供了自动化的质量保证,这将生成汇总统计数据的可视化图表,方便用户在进行分析之前进行检查。

7. “时间就是金钱”

大型数据集需要高性能计算(high-performance computing, HPC),许多研究机构现在都有自己的HPC设施。美国国家科学基金会(US National Science Foundation)负责维护国家高性能计算机网络XSEDE,其中包括基于云计算的网络Jetstream和全国各地的高性能计算机中心。研究人员可以在xsede.org上请求资源分配,并在go.nature.com/36ufhgh上创建试用帐户。其他类似的平台包括美国的ACI-REF网络、NCI澳大利亚、欧洲先进计算合作伙伴关系(Partnership for Advanced Computing in Europe)和ELIXIR网络,以及Amazon、Google和Microsoft等商业提供商。

但说到计算,时间就是金钱。哥本哈根大学(University of Copenhagen)基因组学研究员张国杰(Guojie Zhang)博士表示,为了充分利用他在丹麦的GenomeDK和Computerome集群上的计算时间,他的团队通常在将分析迁移到HPC网络之前进行小规模测试。张是脊椎动物基因组计划(Vertebrate Genomes Project)的一员,该计划正在寻求解析约7万种脊椎动物的基因组。他们需要数百万,甚至数十亿个小时的计算。

8. 记录运行环境

加拿大多伦多玛格丽特公主癌症中心(Princess Margaret Cancer Centre)的计算药物基因组学家Benjamin Haibe Kains指出,要想在以后复制分析结果,你不仅需要同一版本的分析工具,还需要相同的操作系统,以及工具所需的所有相同的软件库。出于这个原因,他建议在一个可以在任何地方组装的独立计算环境(Docker容器)中开展数据分析工作。Haibe Kains和他的团队使用在线平台Code Ocean(基于Docker)来捕获和共享他们的虚拟环境。其他类似的平台包括Binder、Gigantum和Nextjournal。Haibe Kains指出,十年后,如果需要的话,你仍然可以用完全相同的方式运行这些分析。

9. 不要下载数据

下载和存储大型数据集是不实际的。Brown表示,研究人员必须在距离数据存储地点很近的地方进行远程分析。许多大数据项目使用Jupyter笔记本,它创建的文件结合了软件代码、文本和图形。研究人员可以在数据服务器上或附近打开这些文件,进行远程分析和探索数据等。但Brown提醒,习惯使用命令行的研究人员可能不太适应Jupyter笔记本电脑,但是有更多的用户友好平台可以弥合这一差距,包括Terra和Seven Bridges基因组学。

10. 尽早接受培训

即使对年轻的研究人员来说,数据管理也是至关重要的,所以应尽早开始培训。Elmer指出,人们觉得自己从来没有时间来学习数据管理的技能,但从长远来看,尽早开始接受培训可以节省时间。他建议,从命令行的基本知识开始,再加上Python或R之类的编程语言。Lyons同意这一观点:第一步:熟悉来自命令行的数据。去年11月,他的一些不精通命令行用法的合作者就遇到了基因组数据问题,因为染色体名称在他们所有的文件中都不匹配。掌握一些基本的命令行技能和编程,可以更快速地更正染色体名称。

11. 寻求帮助

目前市面有很多在线和离线的帮助资源,比如Stack Overflow。Teal建议,咨询你所在机构的图书管理员,了解你所需要的技能和可用的资源。其中,Carpentries是一个很好的开始。

原文检索:

Anna Nowogrodzki. (2020) Eleven tips for working with large data sets. Nature, 577:439-440. 张洁/编译